Se tenait le samedi 29 juin l’édition chilienne du Scrapathon. Compte rendu.

25 journalistes, développeurs et ingénieurs ont participé samedi 29 juin à l’édition chilienne du Scrapathon.

Se tenait le samedi 29 juin l’édition chilienne du Scrapathon. Compte rendu.

25 journalistes, développeurs et ingénieurs ont participé samedi 29 juin à l’édition chilienne du Scrapathon.

INRIA CHILE organise samedi 29 juin la première édition chilienne du Scrapathon.

Rebaptisé Scrapaton, cet événement se tiendra de 10h à 20h à l’Université Diego Portales à Santiago du Chili et une récompense de 1000 $ viendra récompenser la meilleure équipe.

Tout savoir sur cet événement :

Les premiers résultats du Scrapathon commencent à arriver. Avec un peu de retard, les équipes ont commencé à communiquer les données scrapées.

1ère livraison : la consommation électrique en France du 18 novembre 2010 au 11 juin 2013 référencée sur le site RTE, un travail effectué par Paul.

Consulter et télécharger les données sur DATA PUBLICA

Mercredi 12 juin dernier Data Publica et ses partenaires ont réuni au Dojoboost 41 boulevard Saint-Martin à Paris une communauté de développeurs pour une épreuve ludique et unique, le Scrapathon, consacrée au recueil des données disponibles sur le web.

Avant le début des épreuves, ils étaient près de 50 journalistes, développeurs, ingénieurs, blogueurs et activistes à se réunir dès 16 heures pour se familiariser avec les techniques de scraping dont trois formations étaient dispensées.

Jean-Christophe Combaz, créateur du logiciel Outwit a donné un cours sur l’utilisation de l’un des outils disponibles les plus simples actuellement pour extraire et exporter des données.

La deuxième formation a été dirigée par Samuel Charron, ingénieur R&D chez Data Publica : consacrée aux techniques de scraping Python, elle a réuni une douzaine de personnes.

La troisième formation a été dispensée par Thomas Dudouet, ingénieur R&D chez Data Publica. Ce cours qui a réuni une demi douzaine de participants était centré sur les techniques de scraping Java.

A la suite de ces trois formations, Alan Walter, avocat spécialiste du domaine, a évoqué auprès des développeurs les bonnes pratiques ainsi que les problèmes juridiques à éviter pour un usage respectueux du recueil de données.

Encadrés par un groupe d’ingénieurs, 7 équipes ont alors travaillé de 19 heures à 23 heures 30 sur le recueil de données :

l’équipe 1 s’est concentrée sur le scraping de la carte scolaire à Paris

l’équipe 2 a travaillé sur les délibérations du conseil municipal à Paris

l’équipe 3 s’est penchée sur les données du site Ameli.fr

l’équipe 4 a extrait les données de consommation électriques nationales du site RTE

l’équipe 5 a commencé à recueillir les déclarations publiques d’intérêts des médecins de l’agence du médicament

l’équipe 6 a travaillé sur le site remixjobs pour essayer d’évaluer la part des stages et des CDI proposés

l’équipe 7 s’est attachée au site de la Haute Autorité de Santé pour extraire une liste des médecins certifiés

Presque toutes les équipes ont manqué de temps pour finaliser l’ensemble des tâches d’extraction qu’elles s’étaient fixées. Toutefois, elles se sont engagées à poursuivre leurs efforts et à livrer les données extraites dans les limites des conditions d’utilisation prévues par les sites scrapés.

Seule l’équipe 4 a réussi à extraire totalement dans le temps imparti les données concernant la consommation électrique nationale : un fichier détaillant la consommation électrique par quart d’heure du 16 novembre 2011 jusqu’au 9 juin 2013 sera diffusé jeudi 20 juin.

Dès que les autres équipes auront terminé leur travail de scraping, les données disponibles seront alors traitées et anonymisées si besoin, pour être ensuite diffusées comme prévu sur les sites Data-publica.com et nosdonnees.fr

A noter que samedi 29 juin se tiendra à Santiago du Chili une seconde édition du Scrapathon organisée par les équipes d’INRIA Chile.

Et les premiers vainqueurs de ce scrapathon sont … :

– Prix spécial du Jury pour l’équipe qui s’est occupé de la base Ameli : Cédric, Franck et Martin,

– Prix du public pour l’équipe sur les délibérations du conseil municipal : Perrine, Quentin et Noé.

Le scrapathon passe à la vitesse supérieure : les équipes ont été constituées et commencent à travailler sur leurs sujets concrets. Nous vous proposons une série de billets pour présenter chacune des équipes en lice pour ce 1er scrapathon…

Equipe n°7 – mission : exploiter la liste des médecins certifiés

Membres de l’équipe : Raphael, Frédéric et David.

Se faire opérer par un ophtalmo non certifié ? Toujours possible en 2013 ! Bon, sans dramatiser, il est toujours nécessaire de vérifier que son médecin possède le sésame officiel certifiant sa compétence.

L’objectif de cette équipe: exploiter la liste des médecins certifiés disponible sur le site de la Haute Autorité de Santé, et éventuellement mettre en évidence les établissements qui ont le plus de médecins certifiés.

Le problème: la liste des médecins fournie par l’HAS ne peut pas dépasser 1000 noms pour chaque requête… sur un total de 7000 médecins.

Où en sont-ils ?

Nos scrapers ont contourné cette difficulté en lançant des requêtes sur des unités territoriales dont le nombre de praticiens est inférieur à 1000. Ils ont ainsi pu agréger les données par nom, spécialité, établissements et dates de certification. Par exemple, en Ile de France, le nombre de médecins certifiés est supérieur à 1400, d’où l’idée de lancer les requêtes au niveau des établissements.

Quelles pistes lancent-ils ? Ils proposent de descendre au niveau des établissements pour trouver le taux de certification par spécialité et par établissement. Et de comparer le niveau de certification en fonction des spécialités. Le risque étant de donner un avantage aux grands établissements…Ils proposent également de monter un service pour vérifier que le médecin est bien certifié. Le risque, ici, semble plutôt être juridique..

Le scrapathon passe à la vitesse supérieure : les équipes ont été constituées et commencent à travailler sur leurs sujets concrets. Nous vous proposons une série de billets pour présenter chacune des équipes en lice pour ce 1er scrapathon…

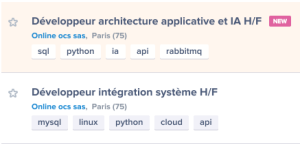

Equipe n°6 – mission : évaluer la part des stages et des CDI offerts selon le compétence demandée (Python, iOS, …)

Membres de l’équipe : Constance, Gaëtan et François.

Les job boards sont une véritable mine d’or pour évaluer la demande sur des compétences particulières. Nos scrappers se sont intéressés au site Remix Jobs qui recense principalement des offres d’emploi (ou de stage !) dans le domaine de l’informatique.

Les job boards sont une véritable mine d’or pour évaluer la demande sur des compétences particulières. Nos scrappers se sont intéressés au site Remix Jobs qui recense principalement des offres d’emploi (ou de stage !) dans le domaine de l’informatique.

Leur objectif : récupérer les données pour être en mesure de les analyser et de les croiser. Un exemple de question : combien de stages proposés pour un CDI pour la compétence Python ? Et pour IOS ?

Où en sont-ils ?

L’heure fatidique d’évaluation des résultats approche 😉

Le scrapathon passe à la vitesse supérieure : les équipes ont été constituées et commencent à travailler sur leurs sujets concrets. Nous vous proposons une série de billets pour présenter chacune des équipes en lice pour ce 1er scrapathon…

Equipe n°5 – mission : récupérer les déclarations publiques d’intérêts des médecins de l’agence du médicament

Membres de l’équipe : Franck, Alexandre et Guillaume.

Le site de l’Agence nationale de sécurité du médicament et des produits de santé (ANSM) contient une base de données très intéressante : Fidnet, la base des déclarations publiques d’intérêts des médecins et experts engagés dans les actions de l’ANSM.

Le site de l’Agence nationale de sécurité du médicament et des produits de santé (ANSM) contient une base de données très intéressante : Fidnet, la base des déclarations publiques d’intérêts des médecins et experts engagés dans les actions de l’ANSM.

C’est quoi le problème ?

La « base » n’est en fait qu’une série de pages web qui recense pour chaque médecin concerné l’ensemble de ses déclarations publiques d’intérêt. On y retrouve notamment les relations avec les laboratoires pharmaceutiques, ainsi que le type de relation (sans rémunération, rémunération personnelle, etc.).

L’idée de nos scrappers : récupérer les données personne par personne pour pouvoir faire des statistiques et des requêtes à partir des données brutes.

Où en sont-ils ?

Ils ont repéré plusieurs autres sites qui proposent des déclarations publiques d’intérêt au-delà de celles déjà publiées sur le site de l’ANSM. Il y a donc l’opportunité aussi de faire du croisement de données sur le sujet.

Le scrapathon passe à la vitesse supérieure : les équipes ont été constituées et commencent à travailler sur leurs sujets concrets. Nous vous proposons une série de billets pour présenter chacune des équipes en lice pour ce 1er scrapathon…

Equipe n°4 – mission : la consommation électrique en France

Membres de l’équipe : Paul, Arnaud, Baptiste

Le site de RTE est une vraie mine d’or pour trouver de l’information sur la production et la consommation d’électricité en France. L’équipe 4 a notamment repéré une très intéressante visualisation dynamique des données en temps réel. Ils souhaitent pouvoir récupérer les données brutes pour en faire des analyses statistiques dans l’outil R.

Le site de RTE est une vraie mine d’or pour trouver de l’information sur la production et la consommation d’électricité en France. L’équipe 4 a notamment repéré une très intéressante visualisation dynamique des données en temps réel. Ils souhaitent pouvoir récupérer les données brutes pour en faire des analyses statistiques dans l’outil R.

C’est quoi le problème ?

Problème intéressant pour cette équipe, et assez unique : en naviguant sur le site, on s’aperçoit que les données brutes sont **déjà** disponibles sur le site de RTE… On apprend souvent, quand on prépare le bac, qu’il faut attentivement lire et relire le sujet avant de se lancer. Visiblement c’est un conseil tout aussi valable pour nos apprentis scrappers 😉

Où en sont-ils ?

Nous sommes en train de leur passer la nouvelle …